Runway Gen-2のマルチモーションブラシの基本と日本人女性を動画化

テキストや画像から動画を生成可能な生成AI、Runway Gen-2から画像中の複数の要素の動きを同時に制御するマルチモーションブラシがリリースされ世界中で話題になっており、今回はマルチモーションブラシの機能を紹介しつつ、実際に画像から動画を生成しその過程をまとめました。

従来の機能の違い

今まで、モーションブラシという機能は用意されていましたが、これは動かせる範囲を指定するものとなりまして、動かしたい領域は指定できるものの細かくオブジェクトごとの動きの調整はできませんでした。

マルチモーションブラシを試す

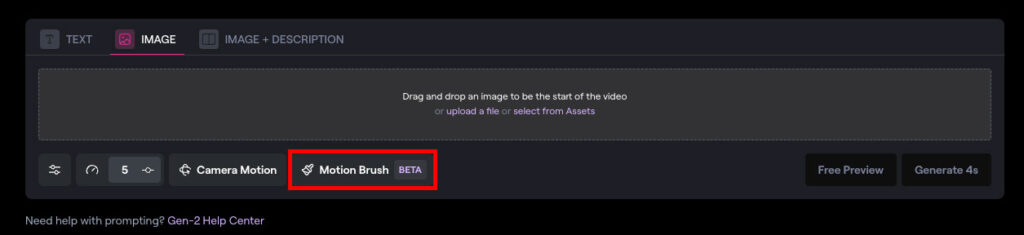

Gen2のimage-to-videoでのみ動作し、設定下部のMotionBrushを選択すると利用可能となります。

マルチモーションブラシの設定

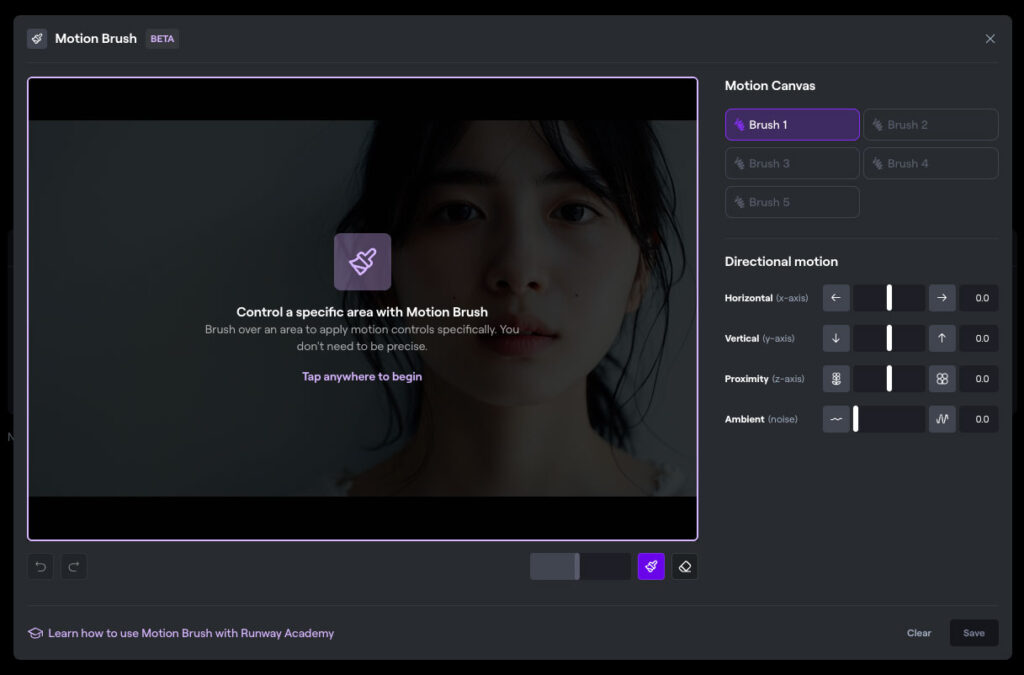

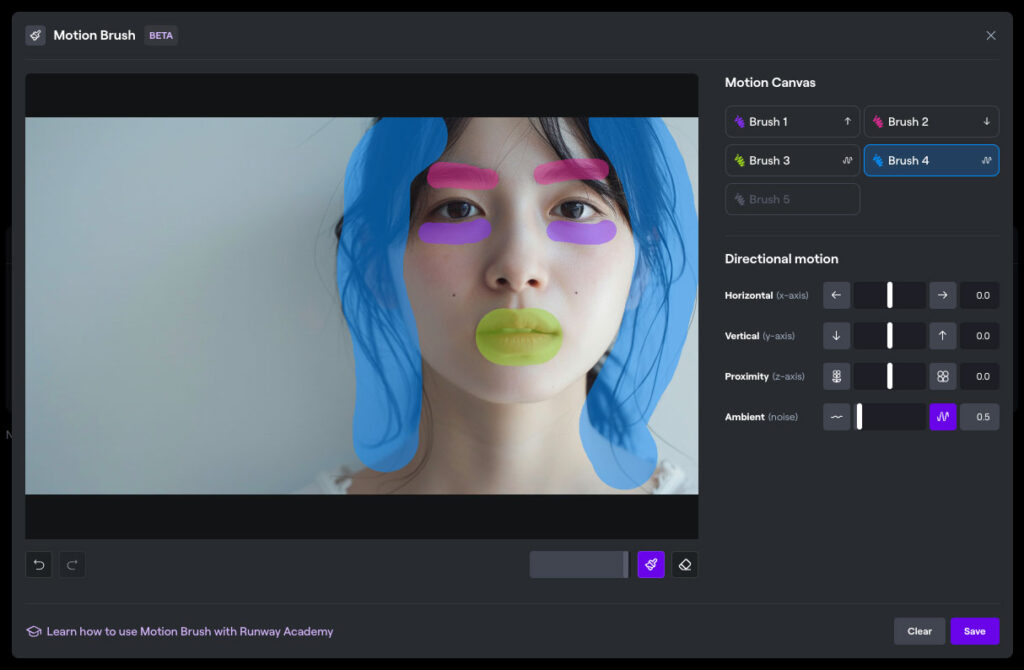

Brushは最大5つまでセットでき、それぞれで、以下のパラメーターを設定可能です。

・Horizontal(横-左右)

・Vertical(縦-上下)

・Proximity(奥行き)

・Ambient(面ゆらぎ)

それぞれのブラシ範囲をどのような動かし方をするかを設定可能です。

設定範囲と数値について

今回は人物をベースにしているので、あまりにも動かしすぎると破綻してしまうので、パラメーターは極めて小さく0.5〜1.0までとしています。

生成した動画

ものすごく動きがあるわけではないですが、目元や口元が動く動画が画像から生成できました。

設定や範囲、元画像次第で可能性は広がる

今回は実写に近い動画でしたが、様々なインプット画像に寄っても領域指定やパラメーターのベストな数字は異なります。かなり奥が深そうですが、可能性はかなり広がった気がします。この機能が追加されたことで、生成AIによる動画生成は一つ進んだ印象をうけました。