ControlNet – Openposeの特性や使い方を解説 / Stable Diffusion web UI

Stable Diffusionの拡張機能、ControlNetのモデルの一つOpenposeモデル。元画像からポーズデータを抽出して、そのポーズを再現するという生成AIのフェーズを一歩前に進めたと言っても過言ではないほどのモデルとなります。

今回はOpenposeの特性や使い方を実際に生成したアウトプットを形成しながら解説して行きたいと思います。

ControlNetの導入について

ControlNetは、Stable Diffusionの拡張機能の一つで、様々なモデルデータと組み合わせて活用することで思い通りの生成結果を導くことができるツールです。

ControlNetのインストールやモデルデータのダウンロードなどについては、「ControlNetをStable Diffusion web uiへインストール」をご覧ください。

ControlNetの「Openpose」の特徴

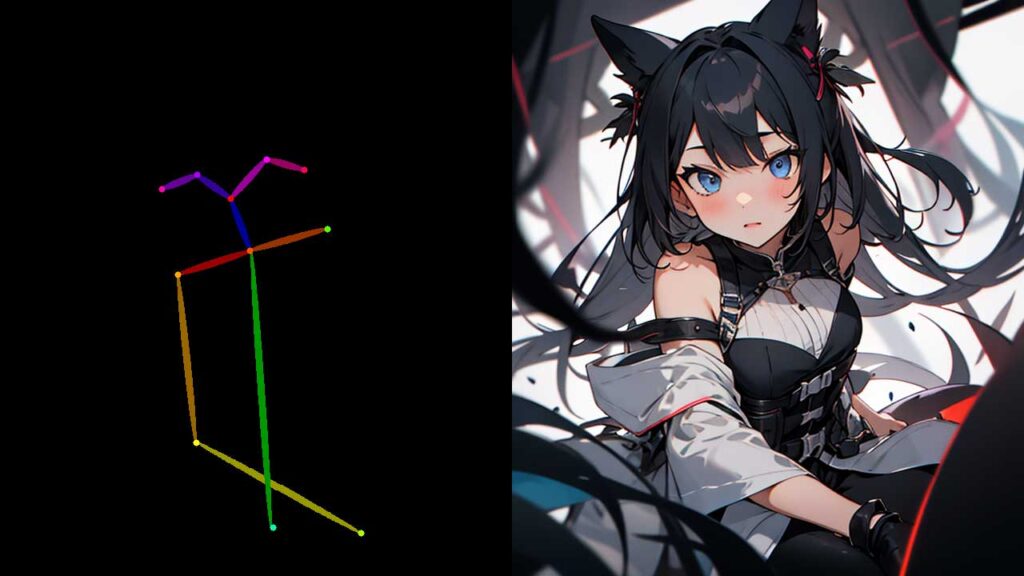

「Openpose」は、いくつかのプリプロセッサが用意されており、「ldw_openpose_full」「openpose」「openpose_face」「openpose_faceonly」「openpose_full」「openpose_hand」の6つのプリプロセッサが用意されていますが、それぞれで抽出するポーズや箇所が異なります。今回はどのようなポーズが取得され、どのようなアウトプットとなるのかを比較しながら実例を生成しました。

冒頭の画像の左側の白髪の女の子が入力データとなります。

「dw_openpose_full」で出力

「openpose」で出力

「openpose_face」で出力

「openpose_faceonly」で出

「openpose_full」で出力

「openpose_hand」で出力

ControlNetの「Openpose」の活用方法

入力画像が小さいとポーズを取り切れない場合がありますので、入力画像は可能であれば可能な限り高解像度のものを利用しましょう。基本はopenposeもしくはopenpose fullで問題はないと思いますが、特に再現したい部分があったり、絞られている際はその他のプリプロセッサを利用しても良いかも知れません。

「Openpose」の特性まとめ

・OpenposeはControlNetで利用可能なモデル

・プロセッサーは6つ有り、ポーズの抽出箇所でプリプロセッサを選択

・ポーズのみを描画する拡張機能Openpose Editerなども有り