ControlNet – Segmentationの特性や使い方を解説 / Stable Diffusion web UI

Stable Diffusionの拡張機能、ControlNetのモデルの一つSegmentationモデル。インプットした画像からオブジェクトを抽出し分類し、それに沿った画像生成が可能なモデルです。

今回はSegmentationの特性や使い方を実際に生成したアウトプットを形成しながら解説して行きたいと思います。

ControlNetの導入について

ControlNetは、Stable Diffusionの拡張機能の一つで、様々なモデルデータと組み合わせて活用することで思い通りの生成結果を導くことができるツールです。

ControlNetのインストールやモデルデータのダウンロードなどについては、「ControlNetをStable Diffusion web uiへインストール」をご覧ください。

ControlNetの「Segmentation」の特徴

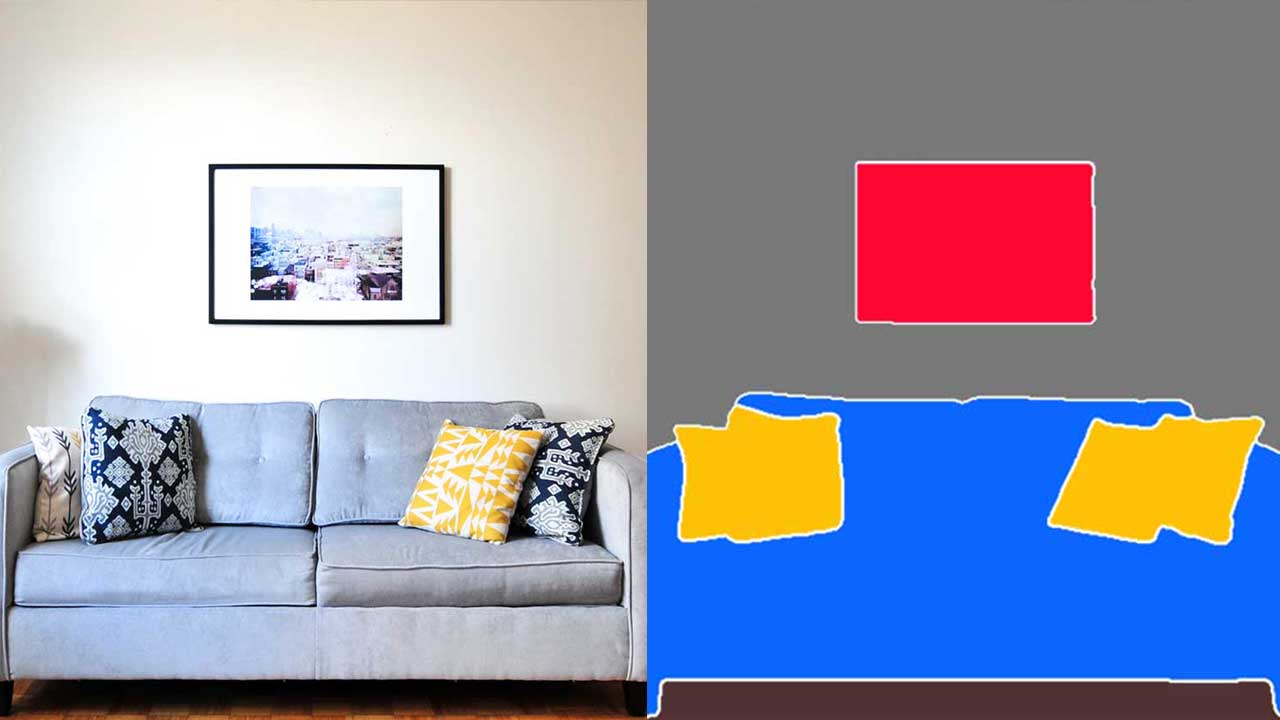

「Segmentation」は、プリプロセッサによってセグメントされる精度や領域が異なります。どの程度、元の画像のオブジェクトを取りたいかで、プリプロセッサを選択したほうが良さそうです。

ControlNetへのインプット

ControlNet「seg_ofada20k」からの解析情報

ControlNet「seg_ofcoco」からの解析情報

ControlNet「seg_ufada20k」からの解析情報

ControlNetの「Segmentation」の活用方法

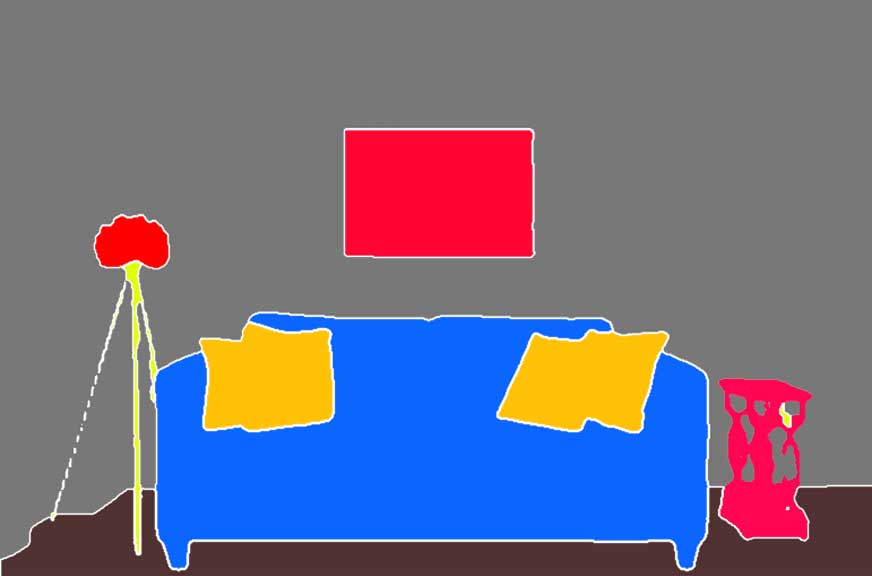

完璧に形をとっているわけではないのですが、元写真で設置されていた家具は全て再現されています。ベースがオブジェクトであれば上手く使えそうなモデルだと思います。

「Segmentation」からの解析情報を元に再生成

「Segmentation」の特性まとめ

・SegmentationはControlNetで利用可能なモデル

・プロセッサーは3つ有り、seg_ofada20kが一番精度が高い

・細かい詳細な形までは完全に取れていないのでオブジェクト自体の再現は難しい